Suchmaschinen schicken Suchroboter durch das Internet, um neue und bestehende Webseiten zu durchsuchen und (neu) zu bewerten. Diese Suchroboter werden auch Crawler, Spider oder Bots genannt.

Da es aber weltweit sehr viele Webseiten gibt, und täglich Unmengen neuer Webseiten hinzukommen, ist es für die Betreiber der Suchmaschinen sehr aufwändig alle diese Webseiten zu besuchen und zu bewerten. Und da es selbst beim Marktführer Google Grenzen bei den technischen Kapazitäten der Bots gibt, crawlen diese Bots selten eine ganze Website an einem Stück, sondern eher einzelne Webseiten.

Aufgrund dieser Beschränkungen bekommt jede Domain daher auch nur ein bestimmtes Crawling-Budget zugeteilt. Dieses Budget legt fest, wie oft und wie viele der Webseiten dieser Domain in einem bestimmten Zeitraum gecrawlt und indexiert werden.

Um dieses zugeteilte limitierte Crawl-Budget bestmöglich zu nutzen, sollten Website-Betreiber die Crawler steuern. Dies geschieht mit Hilfe der Datei „robots.txt“.

Was ist eine robots.txt?

Die robots.txt ist eine reine Textdatei (kein HTML), die sich im Stammverzeichnis der Domain befindet.

Alle Suchmaschinen schicken ihre Crawler und andere Bots zuerst zu dieser robots.txt-Datei, um die dortigen Anweisungen auszulesen. Erst danach wird die eigentliche Webseite ausgelesen. Die robots.txt teilt den Bots dann mit, welche URLs oder Verzeichnisse gecrawlt und welche nicht gecrawlt werden sollen. Welche URLs gecrawlt werden sollen und welche nicht, kann daher grundsätzlich der Betreiber der Website bestimmen.

Im Indexierungsmanagement ist die robots.txt, neben den Meta Tags (z.B. noindex), den Canonical Tags, den Redirects und der Sitemap ein grundlegendes Tool zur Steuerung der Crawler.

Durch die robots.txt können insbesondere große Webauftritte mit einem kleinen Crawling-Budget das Optimum des Crawlings für sich herausholen.

Wofür nutzt man die robots.txt?

Durch die robots.txt kann man das limitierte Crawling-Budget gezielt steuern, um nur die wichtigen Inhalte indexieren zu lassen.

Unwichtige Seiten oder einzelne Elemente, z.B. pdf-Dokumente, können so vom Crawling ausgenommen werden. Sogar ganze Verzeichnisse können auf diesem Wege von dem Crawling ausgenommen werden.

Die so ausgeschlossenen URLs werden dann normalerweise auch nicht in den Suchergebnislisten (SERPs) zu finden sein.

Da die robots.txt im Stammverzeichnis liegt und auch die erste Anlaufstelle für die Bots ist, hat sie als globales Crawling-Steuerungsinstrument für die Website eine Art Weichenstellungsfunktion. Dadurch unterscheidet sie sich auch von den anderen Steuerungselementen Meta-Tags, Canonical Tags und Redirects, die nur eine Steuerung von einzelnen Webseiten ermöglichen.

Wo finde ich die robots.txt?

Die robots.txt ist eine reine Textdatei, die auf dem Webserver ins Stammverzeichnis der Domain gespeichert wird.

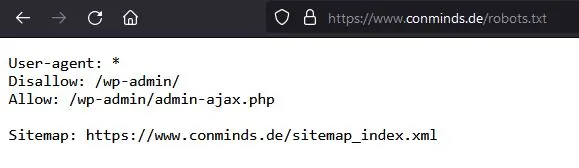

Man kann sie aber ganz einfach mit Hilfe jedes Internetbrowsers auslesen. Dazu muss man nur in das Eingabefeld des Browsers die entsprechende Domain, z.B. „https://www.ihredomain.de“ gefolgt von „/robots.txt“ eingegeben. Insgesamt lautet die URL dann folgendermaßen: „https://www.ihredomain.de/robots.txt“.

Der Browser gibt die robots.txt dann als Textdatei in dem Browserfenster aus. Ist keine robots.txt vorhanden, wird auch keine dargestellt. Auf diese Weise kann die robots.txt allerdings nur angezeigt und nicht bearbeitet werden.

Alternativ kann die Datei natürlich auch direkt vom Webserver per FTP-Client (z.B. FileZilla) ausgelesen werden. Diese Methode hat dann auch den Vorteil, dass die Datei dann direkt bearbeitet werden kann.

Benötigen alle Websites eine robots.txt?

Grundsätzlich gibt es keine Pflicht, dass jede Website auch eine robots.txt haben muss. Sie kann aber für viele Websites ein sinnvolles Instrument für das Indexierungsmanagement sein.

Eine robots.txt ist somit lediglich ein optionales „Tool“, um die Crawler-Tätigkeit innerhalb einer Website zu steuern. Man sollte es aber unbedingt nutzen, wenn man für seine Website einen Vorteil daraus ziehen kann. Im Gegenzug hat das reine Vorhandensein einer fast „leeren“ robots.txt ohne Anweisungen aber auch keine Nachteile.

So benötigt eine kleine Website daher meistens keine robots.txt oder zumindest nur eine mit wenigen Regelungen.

Aber ein umfangreicher Webauftritt und insbesondere ein Online-Shop, der zudem noch ein streng limitiertes Crawling-Budget hat, sollte unbedingt eine robots.txt haben. Solche Websites können von einer robots.txt sehr profitieren. Denn es macht keinen Sinn, z.B. „sinnlose“ Webseiten wie eine Warenkorbseite in einem Online-Shop crawlen und indexieren zu lassen. Das limitierte Crawling-Budget sollte unbedingt nur für die wichtigen Seiten genutzt werden, damit auch alle diese Seiten in den Index der Suchmaschinen aufgenommen werden.

Verhindert die robots.txt die Indexierung?

Nach dem „Robots Exclusion Standard RFC 9309“ müssen Crawler zuerst die Datei „robots.txt“ aus dem Stammverzeichnis lesen, bevor sie eine Webseite auslesen. Die Robots Exclusion Standards sind allerdings keine offiziellen Normen, an die sich die Betreiber der Suchmaschinen halten müssen. Suchmaschinen-Crawler sind somit nicht verpflichtet den Anweisungen in der robots.txt zu folgen. Damit kann man die Anweisungen der robots.txt nur als eine Empfehlung für die Suchmaschinen ansehen. Man kann die Bots somit nicht durch die robots.txt zu einem bestimmten Verhalten zwingen.

Da sich aber die großen Suchmaschinen, insbesondere Google, explizit dazu geäußert haben, dass sie diesen Standard zumindest teilweise befolgen, stellt der Robots Exclusion Standard zumindest eine Art Quasi-Standard dar.

Google zur Befolgung der robots.txt: „Der Googlebot und andere seriöse Web-Crawler befolgen die Anweisungen in robots.txt-Dateien, andere Crawler tun dies jedoch vielleicht nicht.“

ABER auch wenn die Suchmaschinen angeben, sich an die robots.txt zu halten, so sollte die robots.txt definitiv nicht dazu genutzt werden, zu verhindern, dass eine Webseite in den Suchergebnissen der Suchmaschinen auftaucht. Diese Empfehlung spricht selbst Google dazu aus.

Dies hat den Grund, dass eine Webseite auch noch über andere Wege indexiert werden kann. Dies kann z.B. geschehen, wenn ein externer Deep Link auf ihre Webseite zeigt. Kommt der Crawler der Suchmaschine über diesen Link auf ihre Webseite, so wird der Crawler die robots.txt nicht immer beachten. Die Webseite wird dann dennoch gecrawlt und indexiert. Allerdings wird eine auf diesem Wege indexierte Seite in den Suchergebnissen zumindest ohne eine Beschreibung der Seite angezeigt.

Um dies zu verhindern, muss eine andere Methode genutzt werden. Für diesen Zweck gibt es das Meta-Tag „noindex“, das verhindert, dass eine einzelne Webseite indexiert wird. Will man den Zugriff der Crawler auf ein Webdokument komplett unterbinden, sowohl für das Crawling und die Indexierung, so muss man zu weiteren Maßnahmen, z.B. einem Passwortschutz greifen.

Ist eine Webseite bereits indexiert worden und taucht auch bereits in den Suchergebnissen auf, so gibt es wiederum mehrere Methoden sie wieder aus den Suchergebnissen herauszuholen.

Den Bing-Crawlern können sie auch in den Bing Webmaster-Tools mitteilen, wann sie die Website crawlen sollen.

Ist die robots.txt für das SEO relevant?

Das alleinige Vorhandensein einer robots.txt hat noch keinerlei Vorteile für das SEO, denn sie ist kein direkter Rankingfaktor.

Man kann aber durch das gezielte Steuern der Crawler die wichtigen Webseiten öfter crawlen und neue Webseiten schneller crawlen lassen, da das limitierte Crawl-Budget dann nicht für unwichtige Webseiten verschwendet wird.

Zudem können Seiten vom Crawling ausgeschlossen werden, die sonst als Duplicate Content gewertet werden könnten, so z.B. die Druckversionen von Webseiten.

Die robots.txt kann somit auch für SEO-Zwecke eingesetzt werden.

Wie erstellt man eine robots.txt?

Eine richtige “echte” robots.txt muss man manuell erstellen und dann auf den Webserver hochladen.

Aber, bevor Sie nun anfangen eine robots.txt manuell zu erstellen, sollten Sie zuerst mal kurz überprüfen, ob in dem von Ihnen verwendeten Content Management oder Shop-System nicht schon automatisch eine vorkonfigurierte virtuelle robots.txt erzeugt wurde.

Eine solche Datei wird z.B. bei dem Shop-System Shopify automatisch angelegt und fügt ganze Unterverzeichnisse wie /account, /carts, /checkout, /orders, etc. automatisiert in die robots.txt ein.

Jedoch wird die robots.txt nicht unbedingt automatisch durch die reine Installation eines Content Management Systems (CMS) erzeugt. Das kann von CMS zu CMS verschieden sein und sollte daher im Einzelfall geprüft werden.

Virtuelle robots.txt per WordPress erstellen

Das meistgenutzte Content Management System (CMS) WordPress legt mit der Installation auch bereits eine robots.txt an. Allerdings ist die nur eine virtuelle robots.txt, die durch die wp-functions.php-Datei erstellt und ausgegeben wird. Zudem ist diese robots.txt auch nur sehr einfach gehalten, da nur das Verzeichnis /wp-admin/ vom Crawlen ausgenommen wird.

Mit entsprechenden Fachkenntnissen könnte man diese Datei zwar auch modifizieren, jedoch gehen Anpassungen mit dem nächsten Update von WordPress wieder verloren.

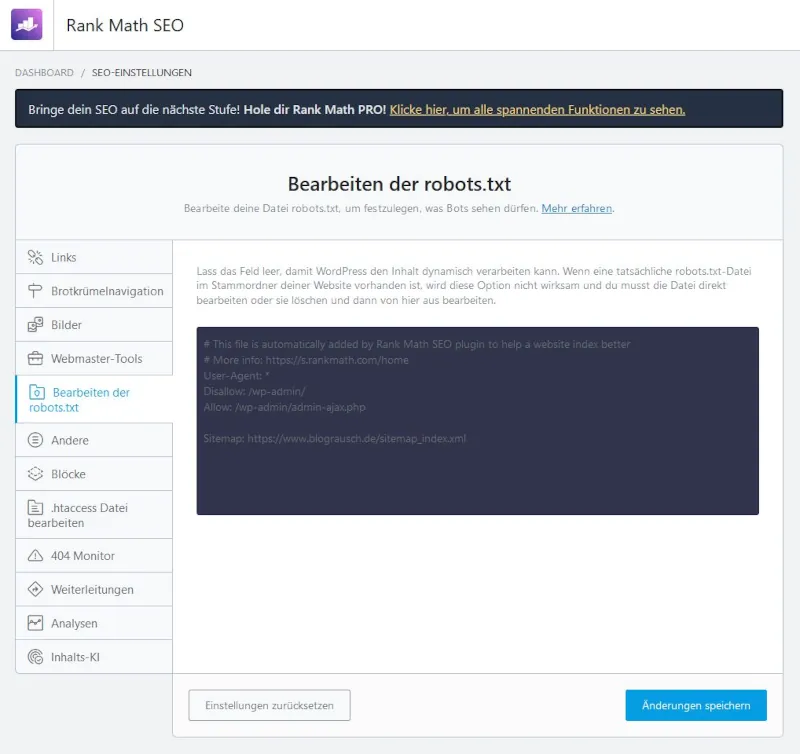

Will man diese virtuelle robots.txt erweitern oder abändern, so kann man dies nur mit Hilfe von zusätzlichen Plugins umsetzen. Dies können besispielsweise die SEO-Plugins Yoast oder RankMath. Allerdings wird auch hiermit nur die virtuelle robots.txt verändert.

Will man keine virtuelle robots.txt, sondern eine echte robots.txt haben, die auch dauerhaft Bestand haben soll, dann muss man diese selbst anlegen und in das Stammverzeichnis (Root) der Domain ablegen. Diese Datei hat dann Vorrang vor den virtuellen robots.txt von WordPress, Yoast oder RankMath.

Manuelle Erstellung der robots.txt

Wird keine robots.txt vom Content Management System (CMS) erstellt und kann auch keine virtuelle Datei über Einstellungen im Backend des Systems erzeugt und geändert werden, so muss diese selbst angelegt und auf den Webserver hochgeladen werden.

Dazu muss man eine Textdatei mit den entsprechenden Anweisungen in das Root-Verzeichnis/Stammverzeichnis der Domain ablegen.

Damit die robots.txt von den Suchmaschinen auch beachtet werden kann, MUSS sich die Datei im Root-Verzeichnis befinden!

Daher muss auch ein unbeschränkter Zugriff des Crawlers auf das Stammverzeichnis (Root-Verzeichnis) möglich sein. Ist der Zugriff auf das Stammverzeichnis aus irgendeinem Grund nicht möglich, z.B. im Rahmen eines beschränkten Website-Hostings, so ist damit das Steuern der Crawler durch die robots.txt auch nicht möglich. In diesem Fall muss auf ein unbeschränktes Webhosting gewechselt werden.

Das Root-Verzeichnis entspricht dem Verzeichnis der Domainebene. So muss die robots.txt für die Domain www.domainname.de über die URL www.domainname.de/robots.txt aufrufbar sein.

Möchte man die robots.txt manuell erstellen, benötigt man dazu noch folgende Dinge:

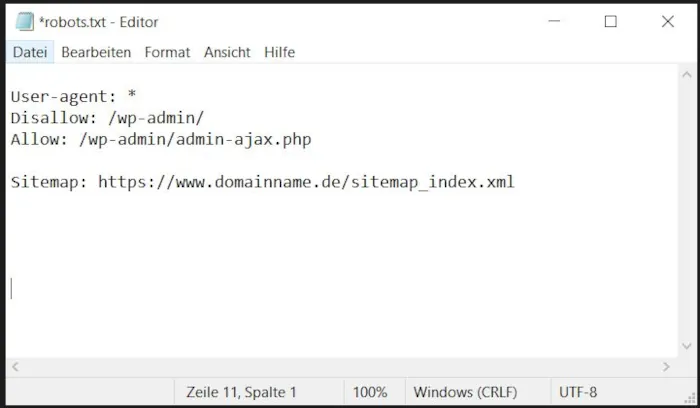

- Text-Editor-Programm, z.B. Windows-Editor (ehemals Notepad) oder TextEditor von Apple. Eine schöne Übersicht von Editoren findet sich bei Wikipedia.

- FTP-Client, z.B. Filezilla oder WebFTP-Zugang (Verfügbarkeit hängt vom Webhosting-Anbieter ab)

Mit dem Texteditor müssen die Anweisungen für die Crawler aufgeschrieben werden und das Ganze mit dem Dateinamen „robots“ im Dateiformat „.txt“ abgespeichert werden.

Wie man eine robots.txt richtig schreibt, beschreibt diese Anleitung von Google.

Alternativ kann man auch einen der kostenlosen robots.txt-Generatoren, die im Netz angeboten werden, nutzen.

Die fertige Datei sollte dann mit dem Google robots.txt Tester auf richtige Funktion geprüft werden.

Anschließend muss sie dann per FTP-Client (z.B. FileZilla) oder WebFTP (wenn der Hosting-Anbieter dies anbietet) auf den Webserver, in das Stammverzeichnis der entsprechenden Domain, gespeichert werden.

Dabei ist zu beachten, dass die Übertragung der Datei per Zeichenkodierung ASCII und nicht binär erfolgt. Bei Filezilla findet man diese Einstellung im Menü unter „Übertragung > Übertragungstyp > ASCII“.

Aufbau der robots.txt

Die robots.txt ist grundsätzlich nach einem bestimmten zweiteiligen Schema aufgebaut:

- Definition der Crawler, für die die nachfolgenden Anweisungen gelten sollen (User-agent)

- Anweisungen für diese Crawler (disallow / allow)

Daneben können optional noch Kommentare eingefügt werden und die URL unter der die XML-Sitemap zu finden ist.

User-Agent definieren

Mit dem Befehl „User-agent:“ in der robots.txt werden die Bots benannt, die sich an die nachfolgenden Crawling-Anweisungen halten sollen.

Beispiele:

User-agent: *

User-agent: Googlebot

Wird hinter dem „User-agent:“ die Wildcard „*“ genutzt, legt man damit fest, dass die folgenden Anweisungen von allen Bots beachtet werden sollen.

Möchte man nur einen bestimmten Bot vom Crawling abhalten, so muss man statt des „*“ diesen Bot, z.B. Googlebot, einfügen.

Die Übersicht der von Google verwendeten Crawler zeigt die Vielfalt der verschiedenen Crawler, die es allein bei Google gibt.

Crawling-Regeln eingeben

Wenn man den Crawler definiert hat, geht es nun in einem zweiten Schritt daran, die Regeln für die entsprechenden Webseiten oder Verzeichnisse zu definieren.

Unter „Disallow:“ werden alle URLs oder Verzeichnisse untereinander aufgelistet, die nicht von den unter „User-agent“ festgelegten Bots gecrawlt werden dürfen.

Mit „Allow:“ können einzelne URLs aus einem Verzeichnis, dass grundsätzlich mit „Disallow“ ausgenommen wurde, wieder zum Crawling hinzugefügt werden. So wird es auch im obigen robots.txt-Beispiel gemacht.

Achtung:

Das Slash „/“ am Ende eines ausgenommenen Verzeichnisses hat große Auswirkungen auf die Anweisungen in der robots.txt.

Daher muss man unbedingt wissen und beachten, dass ein „/“ am Ende eines Verzeichnisses nur das einzelne Verzeichnis vor dem Crawling schützt.

Die Nennung eines Verzeichnisses ohne „/“ am Ende allerdings alle Unterverzeichnisse ebenso einschließt und damit vor dem Crawling schützt.

Ein kleiner, aber folgenreicher Unterschied, der schnell zu einem schwerwiegenden Fehler führen kann.

Weitere tiefergehende Infos zur robots.txt Spezifikation finden Sie bei Google.

Beispiel einer einfachen robots.txt:

User-agent: Googlebot

Disallow: /wp-admin/

Disallow: /orders

Disallow: /cart

Allow: /wp-admin/admin-ajax.php

Optionaler Verweis auf die XML-Sitemap

Optional kann in der robots.txt auch ein Hinweis auf den Ort gegeben werden, an dem die Crawler die XML-Sitemap finden können.

Dies geschieht mit der Funktion „Sitemap:“, gefolgt von dem URL-Pfad, unter dem die XML-Sitemap gespeichert wurde. Das erleichtert dem Crawler die Sitemap der Website zu finden.

Beispiel:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://www.domainname.de/sitemap_index.xml

Kommentar einfügen (Optional)

Man kann nun bei Bedarf in der robots.txt auch einen Kommentar hinzufügen. Dieser dient allein den Menschen, die diese robots.txt lesen werden, nicht den Maschinen (Bots). Maschinen beachten den Kommentar-Text nicht.

Dazu gibt man das Doppelkreuz/Hash „#“ ein, gefolgt von dem entsprechenden Kommentar-Text.

Beispiel:

# Diese robots.txt regelt die Crawler-Steuerung für https://www.deinedomain.de

Weitere wichtige Regeln der robots.txt

Im Folgenden wollen wir noch ein paar wichtige Regeln für die robots.txt erklären.

Allen Crawlern die gleichen Regeln geben

Ist es nicht notwendig den verschiedenen Crawlern jeweils einzelne Regeln zu geben, sondern es genügt, allen Crawlern die gleichen Regeln aufzuerlegen. Dann kann man dies ganz einfach durch die Verwendung der Wildcard „*“ hinter dem „User-agent:“ umsetzen.

Beispiel:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Im Beispiel werden alle Bots angewiesen, das Verzeichnis /wp-admin/ mit Ausnahme der Datei /wp-admin/admin-ajax.php nicht zu crawlen.

Verschiedenen Crawlern unterschiedliche Regeln geben

Wenn man Regeln für mehrere Crawler definieren möchte, so kann man diese in einzelne Blöcke definieren, indem man eine Leerzeile einfügt.

Beispiel:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

User-agent: Googlebot

Disallow: /orders

Disallow: /cart

Im Beispiel wird allen Bots untersagt das Verzeichnis /wp-admin/ außer der Datei /wp-admin/admin-ajax.php zu crawlen. Daneben wird nur der Googlebot gehindert die Verzeichnisse /orders und /cart inklusive deren Unterverzeichnisse zu crawlen. Alle anderen Bots dürfen diese Verzeichnisse aber crawlen.

Einen Crawler für alle Webseiten ausschließen

Auch ist es möglich einen speziellen Bot vom Crawlen aller Webseiten auszuschließen. Dazu nutzt man das Slash-Symbol „/“ hinter dem „Disallow:“.

Beispiel:

User-agent: Googlebot

Disallow: /

Allow: /pictures

Im Beispiel wird der Crawler “Googlebot” angewiesen alle Verzeichnisse nicht zu crawlen. Eine Ausnahme wird aber für das Verzeichnis „/pictures“ inklusive Unterverzeichnisse gemacht. Dieses darf vom Crawler gecrawlt werden.

Bestimmte Dateiarten vom Crawling ausnehmen

Über die robots.txt können zudem bestimmte Dateiarten vom Crawling ausgenommen werden.

Beispiel:

User-agent: *

Disallow: / *.jpg$

Im Beispiel werden alle Crawler angewiesen, in allen Verzeichnissen (aufgrund des Slash-Symbols „/“ hinter dem „Disallow:“) die Dateien mit der Endung „.jpg“ nicht zu crawlen. Dabei wird die Wildcard „*“ als Platzhalter für alle Dateinamen vor der Endung „.jpg“ genutzt. Abgeschlossen wird dieser Befehl mit einem Dollarzeichen „$“.

Crawling-Verzögerung nutzen

Man kann zudem manchen Crawlern mitteilen, dass sie zeitverzögert die einzelnen Seiten crawlen sollen. Dies soll die Belastung des Webservers verringern. Dazu wird die Funktion „Crawl-delay:” genutzt. Die Zahl dahinter gibt die Verzögerung in Sekunden an.

Allerdings unterstützt nicht jeder Crawler diese Funktion. So unterstützen z.B. die Bots von Google diese Funktion nicht.

Beispiel:

User-agent: *

Crawl-delay: 3

Ähnliche Verzeichnisse ausnehmen

Um verschiedene Verzeichnisse die ähnlich lauten, z.B. /datei1/, /datei2/, /datei3/, etc. nicht einzeln ausnehmen zu müssen, kann auch die Wildcard „*“ als Platzhalter für die entsprechenden Unterschiede genutzt werden.

Beispiel:

User-agent: *

Disallow: / datei*/

In diesem Beispiel wird dem Crawler mitgeteilt, dass alle Verzeichnisse, die mit dem Namen „datei“ beginnen nicht gecrawlt werden sollen.

robots.txt testen

Eine robots.txt die fehlerhaft ist, kann allerdings auch einen unerwünschten Effekt haben, nämlich dass gar keine Webseite gecrawlt und indexiert wird. Dies sollte unbedingt vermieden werden.

Um daher sicher zu gehen, dass die robots.txt keine syntaktischen oder logischen Fehler enthält, sollte diese unbedingt mit dem Google Tool „robots.txt-Tester“ geprüft werden. Der robots.txt-Tester befindet sich innerhalb der Google Search Console.

Mit diesem Tool können sogar einzelne User-Agent auswählt werden, mit dem die robots.txt getestet werden soll.

Als Ergebnis gibt dieses Tool alle Fehler als Syntaxwarnung oder logischer Fehler der Datei aus.

Das Tool setzt allerdings voraus, dass sie einen Google-Account und ihre Domain bei der Google Search Console angemeldet haben.

Zudem kann es nur Domains testen, die per URL-Präfix-Property angelegt wurden. Haben sie ihre Domain als Domain-Property angelegt, so können sie den robots.txt-Tester nicht unmittelbar nutzen. Aber ein kleiner Trick hilft dies zu umgehen: Legen sie in der Search Console einfach noch neben der Domain-Property ihrer Domain eine weiterer URL-Präfix-Property der gleichen Domain an. Diese können problemlos nebeneinander angelegt werden und so können sie den robots.txt-Tester dennoch nutzen.

Das Pendant inklusive robots.txt-Tester von Microsoft befindet sich in den Bing Webmaster Tools.

Fazit

Die robots.txt ist ein gutes Tool um die Crawler der Suchmaschinen steuern zu können, insbesondere wenn eine Website umfangreich ist und das Crawling-Budget stark limitiert ist. Man findet die Anweisungen an die Crawler in der robots.txt-Datei. Diese ist unter dem Domain-Zusatz “/robots.txt” aufrufbar.

Das Content Management System WordPress legt eine robots.txt automatisch an. Dies ist jedoch nur eine virtuelle robots.txt-Datei, die nicht geändert werden kann. Eine echte robots.txt muss manuell angelegt und in das Stammverzeichnis der Domain hochgeladen werden.

Allerdings verhindert die robots.txt nicht eine Indexierung der in der robots.txt-Datei ausgenommenen URLs. Eine Indexierung der Webseiten muss einzeln über das Meta-Tag “noindex” oder einen Passwortschutz verhindert werden.

Weiterführende Informationen:

Google`s Einführung zur robots.txt: https://developers.google.com/search/docs/crawling-indexing/robots/intro

Wie Google die robots.txt interpretiert: https://developers.google.com/search/docs/crawling-indexing/robots/robots_txt

Anleitung zum Schreiben einer robots.txt: https://developers.google.com/search/docs/crawling-indexing/robots/create-robots-txt

Crawler-Steuerung von Bing: https://www.bing.com/webmasters/help/crawl-control-55a30303

Virtuelle Robots.txt per RankMath ändern: https://rankmath.com/kb/how-to-edit-robots-txt-with-rank-math/

robots.txt-Datei aktualisieren: https://developers.google.com/search/docs/crawling-indexing/robots/submit-updated-robots-txt

Google`s robots.txt-Tester: https://www.google.com/webmasters/tools/robots-testing-tool

Kurze Anleitug zu Google`s robots.txt-Tester: https://support.google.com/webmasters/answer/6062598

Bing`s robots.txt-Tester: https://www.bing.com/webmasters/robotstxttester

Bing`s robots.txt-Tester: https://www.bing.com/webmasters/help/robotstxt-tester-623520ca

FAQ – Häufig gestellte Fragen & Antworten

Was ist eine robots.txt?

Die robots.txt ist eine Textdatei, die im Stammverzeichnis (Root-Directory) einer Webseite abgespeichert ist. Sie steuert die Crawler, indem sie über die Befehle “allow” und “disallow” definiert, welche URLs gecrawlt werden sollen und welche nicht.

Braucht jede Webseit eine robots.txt?

Nein, eine robots.txt ist ein rein optionales Tool. Damit lassen sich die Crawler steuern und so ein limitiertes Crawlig-Budget optimal nutzen. Allerdings legen manche Content Management Systeme, so auch WordPress, bei der Installation eine nicht änderbare virtuelle robots.txt an.

Was macht die robots.txt?

Die robots.txt steuert die Crawler, indem sie bestimmte URLs oder Verzeichnisse vom Crawling-Prozess ausnimmt. Dies erlaubt eine optimale Ausschöpfung des meist begrenzten Crawling-Budgets für jede Website.

Wie kann ich die robots.txt einsehen?

Ganz einfach mit Hilfe jedes Internet-Browsers. Dazu geben sie in das Eingabefeld des Browsers ihre Domain ein, gefolgt von der Endung „/robots.txt“. Dies sieht dann folgendermaßen aus: https://www.ihredomain.de/robots.txt. Nachdem sie die Enter-Taste gedrückt haben, wird Ihnen im Browserfenster der Textinhalt der robots.txt angezeigt.

Wie bearbeite ich die robots.txt?

Die echte robots.txt kann nur manuell mit Hilfe eines Editor-Programms erstellt/bearbeitet werden und muss dann in das Stammverzeichnis der Domain hochgeladen werden. Mit Hilfe von Plugins wie RankMath oder Yoast kann allerdings die von WordPress automatisch erstellte virtuelle robots.txt geändert werden.

Halten sich alle Crawler an die robots.txt?

Grundsätzlich sind die Anweisungen der robots.txt nur als eine Art Empfehlung oder Richtlinie für die Crawler der Suchmaschinen anzusehen. Jedoch sagt Google und die anderen großen Suchmaschinen von sich, dass sie die Anweisungen in der robots.txt befolgen.

Kann ich Webseiten per robots.txt vor Google verstecken?

Nein. Eine Webseite, die in der robots.txt vor dem Crawling geschützt werden soll, kann immer noch auf anderem Wege indexiert werden. Dies kann vor allem durch externe Links auf diese Webseite geschehen. Wenn Google diesem Link folgt und so auf diese Webseite geführt wird, wird die globale Datei robots.txt nicht unbedingt beachtet und die Webseite daher indexiert. Will man eine Indexierung verhindern, muss man dies mit dem Meta-Tag „noindex“ auf der entsprechenden Webseite oder einem Passwortschutz verhindern.

Legt WordPress automatisch eine robots.txt an?

Ja, WordPress legt mit der Installation automatisch die Datei robots.txt an. Allerdings ist dies nur eine virtuelle robots.txt die auch nur sehr einfach gehalten ist, da sie lediglich das Verzeichnis „/wp-admin/“ für alle Crawler vom Crawling ausnimmt.